自駕車(AI)的兩難

自駕車(AI)的兩難

圖片來源:https://reurl.cc/qNkGeR

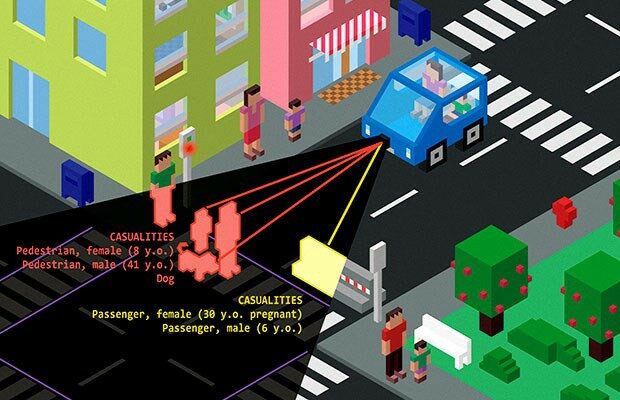

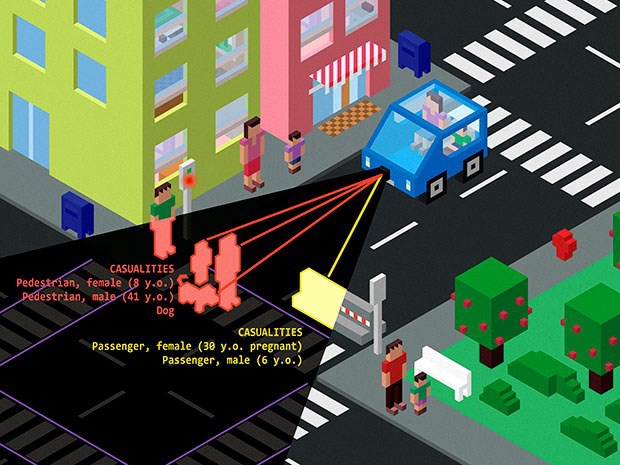

著名的火車難題:剎車失靈的火車軌道前方有五個人,空軌道上有一個人,而你又握有能夠掌控火車行進方向的操縱桿時,你會改變火車行駛方向嗎?

多數人選擇犧牲少數,但如果加入親人、仇人、一隻狗等文化與種族因素,或甚至要你親手殺一個人拯救另五個人時的道德比較時,答案的選擇就更糾結了。當人面對如此情境,都無法有統一的共識時,我們如何要求自駕車能確保百分之一百的正確判斷?或者說,應該先定義什麼是正確?

AI是自駕車的大腦,決定了自駕車在面臨狀況時如何判斷。但AI的判斷資料由誰提供,決定結果?

就像MIT麻省理工學院曾做過一個實驗,透過餵食大量極端不安的資料,產出如同希區考克驚魂記中的Norman,不論解讀怎樣的文本,都將產生令人毛骨悚然的判斷。極端的實驗,反映出的是人類帶有偏見,而我們如何讓AI不帶偏見?

科技沒有善惡之分,但也絕非中性。google、FB、假新聞與內容農場其實都在肅立偏見,而這些會是AI的養分嗎?可能性很大!我們能夠做的或許是用盡全力想辦法踩剎車,而不是當神主宰世界。

德國在2017年訂定了自駕車的倫理規則:優先考慮人類的生命、不分個人特徵做決策(如:膚色、年齡、性別等)、必須保存資料並有權決定是否給第三方,及如何使用。這是2017年首開先例的規範,但我不認為必是未來,文化的變化形塑自駕車的AI倫理觀,而阻止自駕車失控的剎車器在我們手上,不應該交付給操縱桿。

本文作者|被便利商店耽誤的設計師

BLOG|未來超商 WELABAR

便利商店/數位轉型/服務設計/服務創新/零售流通產業資訊